DeepSeek R1 本地部署+本地API调用+SpringBoot调用本地DeepSeek API实用教程、集成VS Code、JetBrains等开发工具中

一、准备工作

① 注册地址

👉 点击进入官网注册

② 本地部署 工具Ollama

一个免费使用、本地运行、具有隐私意识的聊天机器人。无需 GPU 或互联网。

👉 Ollama安装和使用视频教程

👉 Ollama安装 + 网页插件视频教程

👉 点击官网下载Ollama地址

部署命令:

1.5B Qwen DeepSeek R1

1 | ollama run deepseek-r1:1.5b |

7B Qwen DeepSeek R1

1 | ollama run deepseek-r1:7b |

8B Llama DeepSeek R1

1 | ollama run deepseek-r1:8b |

14B Qwen DeepSeek R1

1 | ollama run deepseek-r1:14b |

32B Qwen DeepSeek R1

1 | ollama run deepseek-r1:32b |

70B Llama DeepSeek R1

1 | ollama run deepseek-r1:70b |

二、硬件配置说明

- Windows 配置:

最低要求:NVIDIA GTX 1650 4GB 或 AMD RX 5500 4GB,16GB 内存,50GB 存储空间

推荐配置:NVIDIA RTX 3060 12GB 或 AMD RX 6700 10GB,32GB 内存,100GB NVMe SSD

高性能配置:NVIDIA RTX 3090 24GB 或 AMD RX 7900 XTX 24GB,64GB 内存,200GB NVMe SSD - Linux 配置:

最低要求:NVIDIA GTX 1660 6GB 或 AMD RX 5500 4GB,16GB 内存,50GB 存储空间

推荐配置:NVIDIA RTX 3060 12GB 或 AMD RX 6700 10GB,32GB 内存,100GB NVMe SSD

高性能配置:NVIDIA A100 40GB 或 AMD MI250X 128GB,128GB 内存,200GB NVMe SSD - Mac 配置:

最低要求:M2 MacBook Air(8GB 内存)

推荐配置:M2/M3 MacBook Pro(16GB 内存)

高性能配置:M2 Max/Ultra Mac Studio(64GB 内存)

可根据下表配置选择使用自己的模型

| 模型名称 | 参数量 | 大小 | VRAM (Approx.) | 推荐 Mac 配置 | 推荐 Windows/Linux 配置 |

|---|---|---|---|---|---|

| deepseek-r1:1.5b | 1.5B | 1.1 GB | ~2 GB | M2/M3 MacBook Air (8GB RAM+) | NVIDIA GTX 1650 4GB / AMD RX 5500 4GB (16GB RAM+) |

| deepseek-r1:7b | 7B | 4.7 GB | ~5 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 8GB / AMD RX 6600 8GB (16GB RAM+) |

| deepseek-r1:8b | 8B | 4.9 GB | ~6 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 Ti 8GB / AMD RX 6700 10GB (16GB RAM+) |

| deepseek-r1:14b | 14B | 9.0 GB | ~10 GB | M2/M3/M4 Pro MacBook Pro (32GB RAM+) | NVIDIA RTX 3080 10GB / AMD RX 6800 16GB (32GB RAM+) |

| deepseek-r1:32b | 32B | 20 GB | ~22 GB | M2 Max/Ultra Mac Studio | NVIDIA RTX 3090 24GB / AMD RX 7900 XTX 24GB (64GB RAM+) |

| deepseek-r1:70b | 70B | 43 GB | ~45 GB | M2 Ultra Mac Studio | NVIDIA A100 40GB / AMD MI250X 128GB (128GB RAM+) |

| 模型参数规模 | 典型用途 | CPU 建议 | GPU 建议 | 内存建议 (RAM) | 磁盘空间建议 | 适用场景 |

|---|---|---|---|---|---|---|

| deepseek-r1:1.5b(15亿) | 小型推理、轻量级任务 | 4核以上 (Intel i5 / AMD Ryzen 5) | 可选,入门级 GPU (如 NVIDIA GTX 1650, 4GB 显存) | 8GB | 10GB 以上 SSD | 小型 NLP 任务、文本生成、简单分类 |

| deepseek-r1:7b(70亿) | 中等推理、通用任务 | 6核以上 (Intel i7 / AMD Ryzen 7) | 中端 GPU (如 NVIDIA RTX 3060, 12GB 显存) | 16GB | 20GB 以上 SSD | 中等规模 NLP、对话系统、文本分析 |

| deepseek-r1:14b(140亿) | 中大型推理、复杂任务 | 8核以上 (Intel i9 / AMD Ryzen 9) | 高端 GPU (如 NVIDIA RTX 3090, 24GB 显存) | 32GB | 50GB 以上 SSD | 复杂 NLP、多轮对话、知识问答 |

| deepseek-r1:32b(320亿) | 大型推理、高性能任务 | 12核以上 (Intel Xeon / AMD Threadripper) | 高性能 GPU (如 NVIDIA A100, 40GB 显存) | 64GB | 100GB 以上 SSD | 大规模 NLP、多模态任务、研究用途 |

| deepseek-r1:70b(700亿) | 超大规模推理、研究任务 | 16核以上 (服务器级 CPU) | 多 GPU 并行 (如 2x NVIDIA A100, 80GB 显存) | 128GB | 200GB 以上 SSD | 超大规模模型、研究、企业级应用 |

| deepseek-r1:671b(6710亿) | 超大规模训练、企业级任务 | 服务器级 CPU (如 AMD EPYC / Intel Xeon) | 多 GPU 集群 (如 8x NVIDIA A100, 320GB 显存) | 256GB 或更高 | 1TB 以上 NVMe SSD | 超大规模训练、企业级 AI 平台 |

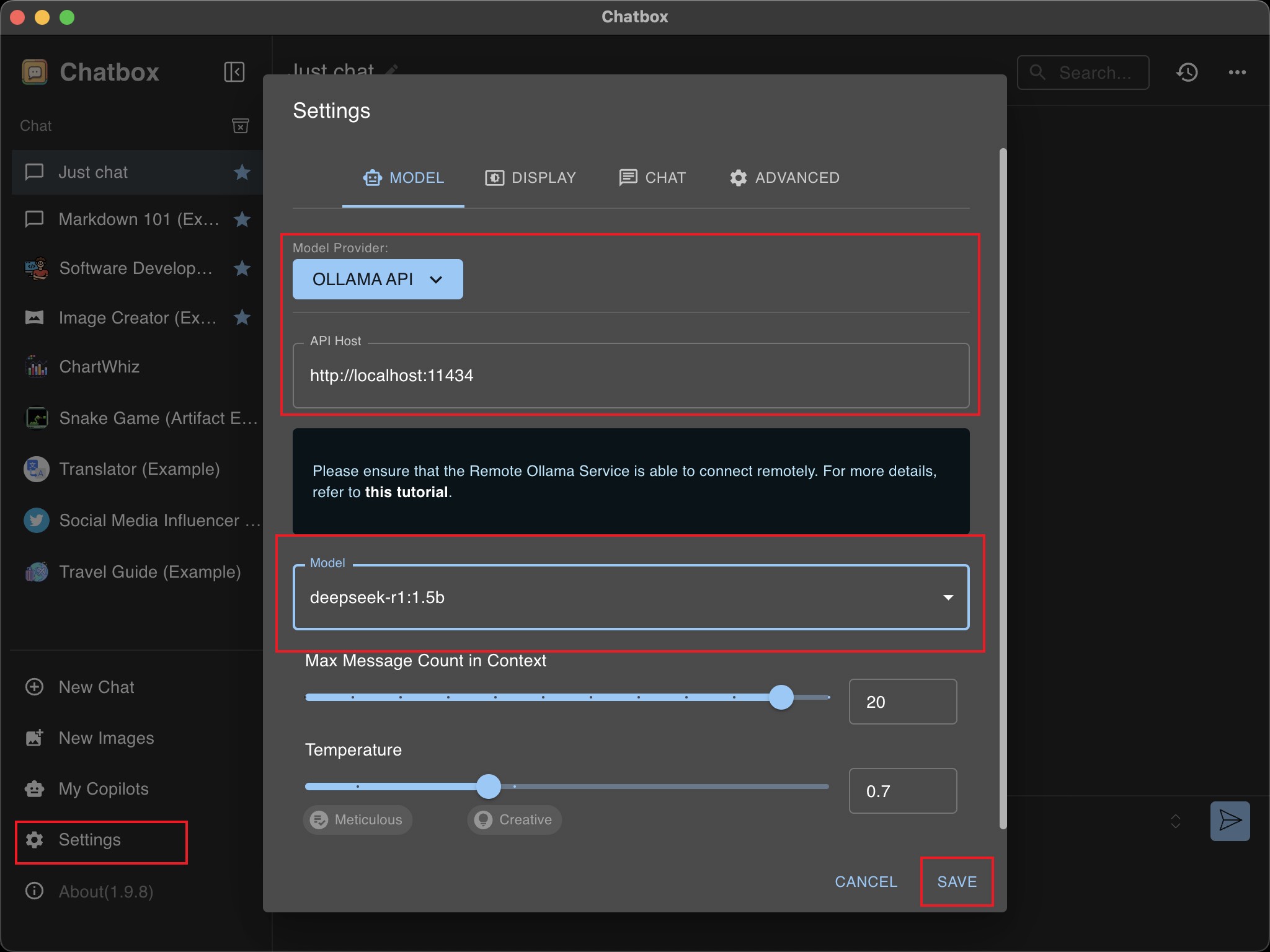

三、ChatBox本地API调用教程

1 | 我正在写一篇文章,手动部署DeepSeek本地模型,调用本地API使用教程。请你帮我生成10个吸引眼球的标题供我选择。 |

四、SpringBoot本地API调用教程

使用Ollama部署deepseek-r1大模型,我们就可以开始使用Spring Boot + Spring AI来调用deepseek-r1大模型了

点击下载SpringBoot代码地址

IDEA开发工具下载地址

① 点击官网构建Spring Boot项目

② 点击ADD DEPENDENCIES,搜索Ollama添加依赖,这是Spring AI对 Ollama 的实现支持。

③ 打开生成的项目,查看pom.xml,可以看到核心依赖:

1 | <dependency> |

说明:如果你要在现有项目中集成的话,就可以直接添加这个依赖即可。

④ 配置Ollama的相关信息:application.properties或application.yml

1 | spring.ai.ollama.base-url=http://localhost:11434 |

说明:Ollama API 默认调用端口号:11434

⑤ 写个单元测试,尝试调用Ollama中的deepseek-r1模型,这里尝试实现一个翻译的功能

1 |

|

⑥ 运行单元测试,结果如下:

1 | <think> |

可以看到结果响应分成两部分,先是 <think> 标签包含的内容,这是模型根据提供的提示,生成了一个思考的过程,最后才输出了翻译后的结果。

五、集成VS Code、JetBrains等开发工具

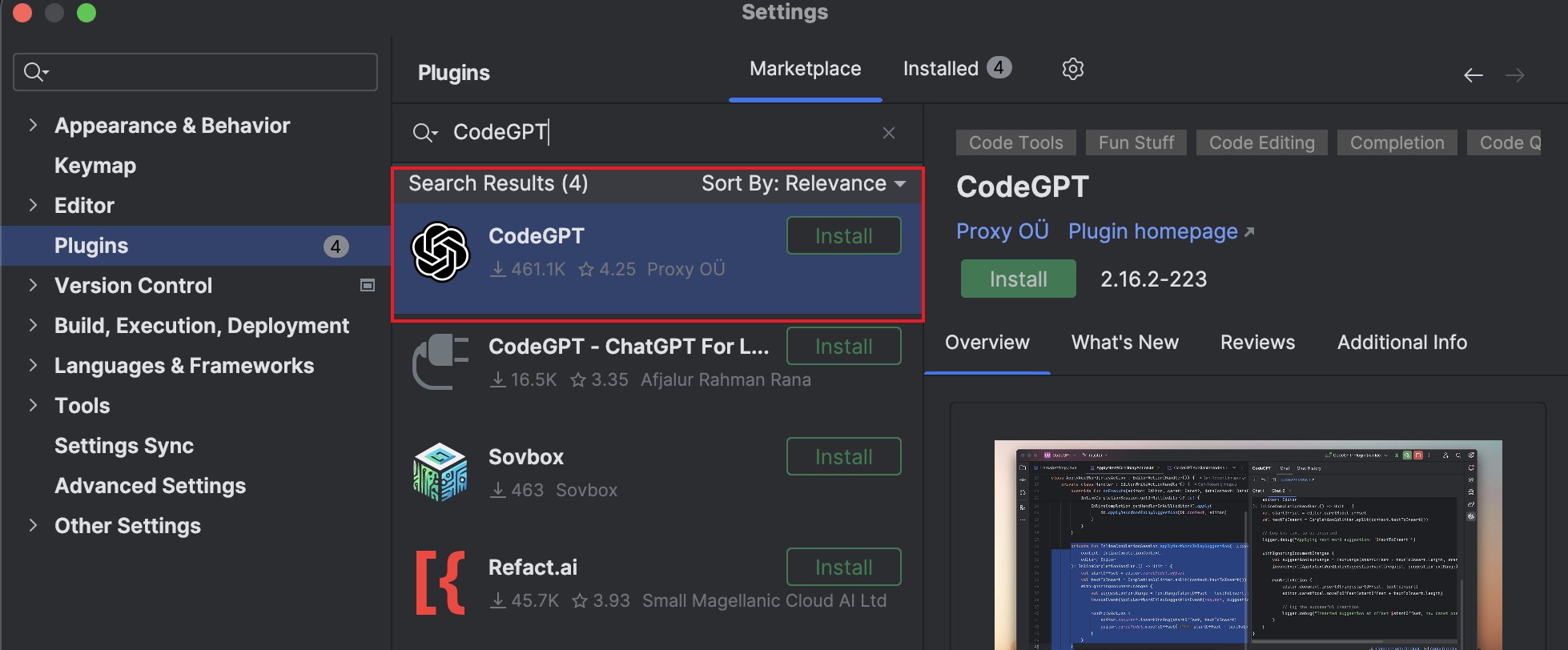

① IDEA工具安装 CodeGPT 插件 或 Continue 插件

IDEA开发工具下载地址

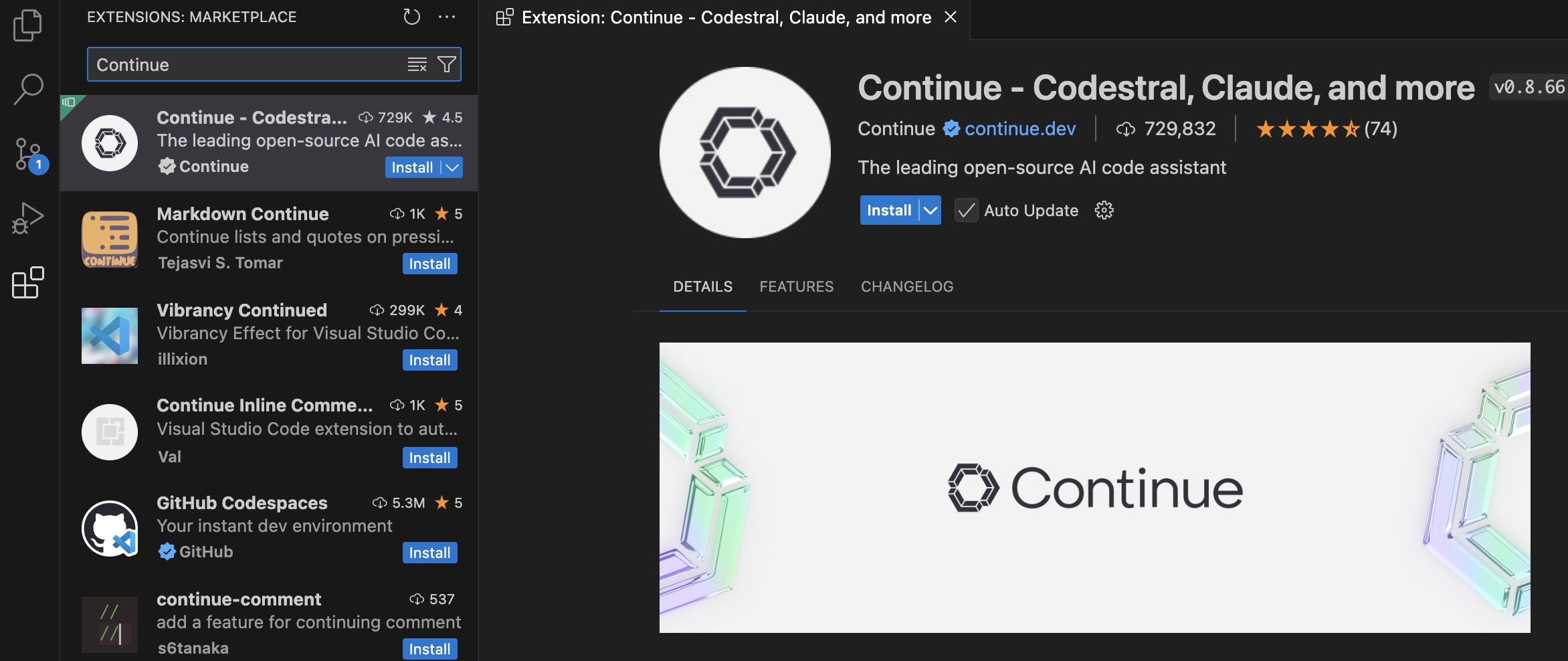

② VS Code工具安装 CodeGPT 插件或 Continue 插件

VS Code开发工具下载地址

➖➖相关视频推荐教程➖➖

- 点击观看调用本地API+SpringBoot调用本地API 教程

- 点击观看DeepSeek R1大模型多方式本地部署实用教程

- 点击观看全免费ChatGPT桌面版本win安装

- 点击观看💰AI制作快速3D动画影片,📈 轻松在家赚钱教程

- 点击观看Llama3.1一键本地部署最强开源大模型教程

- 点击观看免费GPT-4o教程

- 点击观看AI分享、人工智能所有教程

▶️ 新人YouTube 需要您的支持,请务必订阅频道帮我点赞、关注、打开小铃铛,十分感谢!!!

✅在Fork项目时,请 follow 我的GitHub、给我所有项目一个 Star 星星支持下!你的支持是我不断前进的动力! 💖

✅解锁更多技能 加入TG群【am_clubs】、YouTube频道【@am_clubs】、【博客(国内)】、【博客(国际)】

✅点击观看免费节点教程 | 免费服务器教程 | 免费域名教程 | 免费VPN教程 | 免费IPTV教程 | Mac和Win工具教程 | AI分享教程

[点击展开] 赞赏支持 ~🧧

*我非常感谢您的赞赏和支持,它们将极大地激励我继续创新,持续产生有价值的工作。*- USDT-TRC20:

TWTxUyay6QJN3K4fs4kvJTT8Zfa2mWTwDD - TRX-TRC20:

TWTxUyay6QJN3K4fs4kvJTT8Zfa2mWTwDD

免责声明:

- 1、该项目设计和开发仅供学习、研究和安全测试目的。请于下载后 24 小时内删除, 不得用作任何商业用途, 文字、数据及图片均有所属版权, 如转载须注明来源。

- 2、使用本程序必循遵守部署服务器所在地区的法律、所在国家和用户所在国家的法律法规。对任何人或团体使用该项目时产生的任何后果由使用者承担。

- 3、作者不对使用该项目可能引起的任何直接或间接损害负责。作者保留随时更新免责声明的权利,且不另行通知。

【银河录像局】 奈飞账号合租,Ai账号多模型国内直连,性价比拉满

🌐点击官网:【nf.video】注册 🎁95折优惠码:amclubs

【红杏云】 中转高速机场,8元220G/每月✅玩游戏首选,解锁ChatGPT、全流媒体(送小火箭)【送自动签到脚本】

🌐点击官网【https://hongxingdl.com】注册 🎁8折优惠码:AM科技

【极速云】 全专线机场 低至8元100G/每月✅全IEPL专线,畅爽晚高峰 解锁ChatGPT、全流媒体(送小火箭)

🌐点击官网【https://极速666.com】注册 🎁8折优惠码:AM888

【69云】 中转高速机场 9.9元400G/每月✅看片秒加载,解锁ChatGPT、全流媒体(送小火箭)【送自动签到脚本】

🌐点击官网【https://69yun69.com】注册

评论

发表评论